Rýchly vývoj umelej inteligencie je trendom dnešnej doby. Modely spoločnosti OpenAI už stihli mnohé spoločnosti začleniť do firemných procesov a mnoho z nás ich používa denne. Čo sa môže stať, keď zamestnanci prostredníctvom promptov zadávajú do týchto modelov citlivé informácie? A aký typ dát by ste nikdy nemali zdieľať s ChatGPT a prečo?

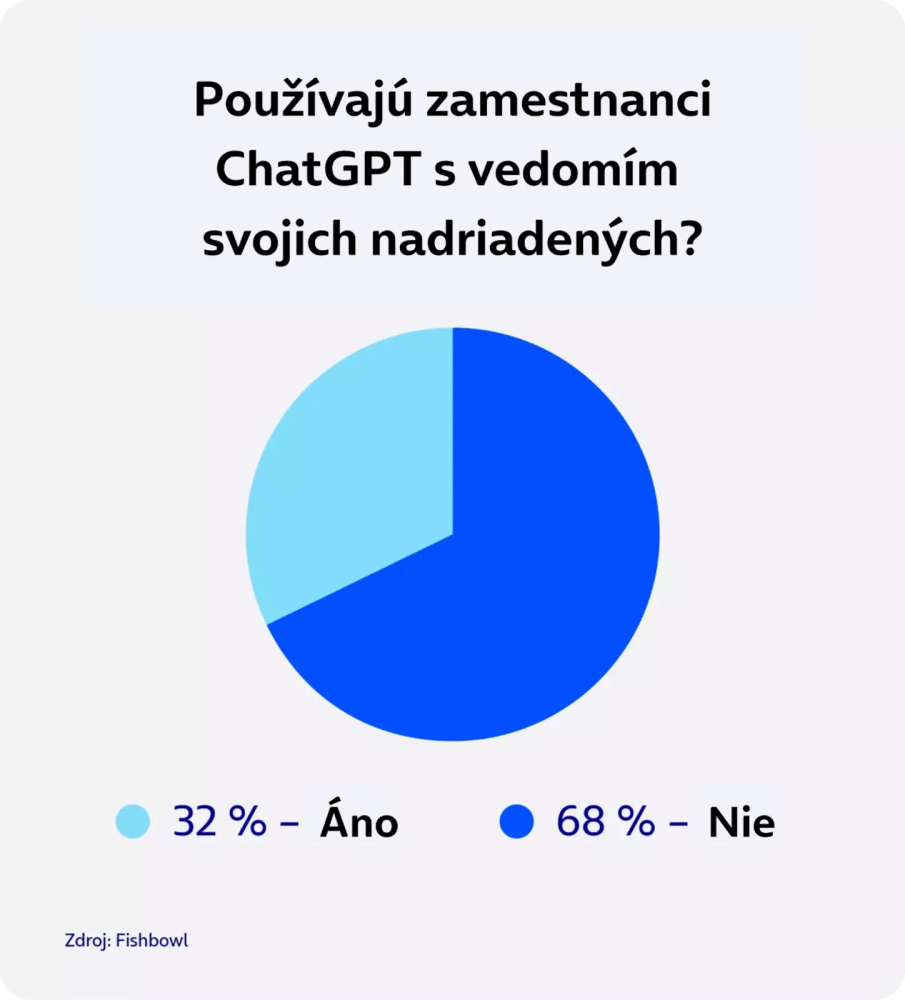

V roku 2022 sa dostala do povedomia verejnosti najmä generatívna umelá inteligencia na báze veľkých jazykových modelov. Tie nasledujúci rok začala používať prevažná väčšina z nás. Potvrdzuje to aj prieskum spoločnosti Fishbowl z vlaňajšieho februára: 43 % profesionálov použilo nástroje ako ChatGPT, ale takmer 70 % z nich to robilo bez vedomia svojho nadriadeného.

Podľa nedávneho prieskumu spoločnosti IBM, ktorého sa zúčastnilo viac ako 1000 zamestnancov, medzi hlavné faktory, ktoré prispeli k rýchlemu prijatiu AI vo firmách patria:

pokrok vo vývoji nástrojov, ktoré sa zároveň stali dostupnejšími,

potreba znižovať náklady a automatizovať kľúčové procesy vo firmách,

rastúce množstvo AI zabudované do štandardných hotových podnikových aplikácií.

AI prináša príležitosti, ale aj riziká

Príležitosti, ktoré AI ponúka, sprevádzajú aj riziká. „Pre úspešnú a bezpečnú implementáciu generatívnej umelej inteligencie do business prostredia je potrebné, aby firma svojich zamestnancov podporovala v znalosti nielen jej možností, ale aj limitov a prípadných rizík. Dôležité je tiež dodržiavanie odporúčaní z oblasti data privacy a ich znalosť pri AI nástrojoch, ktoré firma postupne začleňuje do svojej prevádzky,“ hovorí Petr Hirš, riaditeľ O2 kompetenčného centra pre umelú inteligenciu Dataclair. „V O2 naplno podporujeme zavádzanie AI technológií, ale bezpečne. Zamestnanci ich využívajú bežne, napríklad prostredníctvom integrácie zabezpečenej inštancie ChatGPT priamo do firemného komunikátora MS Teams alebo vďaka asistentovi Virtuálnemu Buddymu pri obsluhe zákazníkov v rámci našich zákazníckych centier.“

Existuje aj mnoho firiem, ktoré svojim zamestnancom prácu s chatbotmi zakazujú.

To je prípad spoločnosti Samsung Electronics, u ktorej prišlo k úniku citlivých informácií práve kvôli chatbotom. Vedenie následne svojim zamestnancom zakázalo používať ChatGPT a ďalšie chatboty s umelou inteligenciou z obavy z úniku ďalších informácií, ako sú interné kódy, materiály chránené autorskými právami, obchodné tajomstvo, osobné údaje zamestnancov a ďalšie dôverné obchodné informácie.

Samsung čoskoro nasledovala aj spoločnosť JPMorgan Chase, ktorá svojim zamestnancom tiež výrazne obmedzila používanie ChatGPT kvôli obavám, že by mohla čeliť potenciálnym regulačným rizikám spojeným so zdieľaním citlivých finančných informácií. Pridali sa k nej aj ďalšie veľké americké banky - vrátane Bank of America, Citigroup, Deutsche Bank, Wells Fargo alebo Goldman Sachs.

Najčastejšie využívané modely Al v roku 2024

OpenAl - Pod spoločnosť OpenAl, do ktorej výrazne investuje Microsoft, spadajú modely GPT (GPT-4, GPT-3.5 a najnovšie GPT-40) a ďalej modely špecifické pre jednotlivé funkcie. Medzi ne patrínapríklad DALL-E na tvorbu obrázkov, Whisper na prevod hovoreného slova do textovej podoby alebo Moderation, ktorý slúži na rozpoznávanie vulgarizmov a nenávistných textových prejavov.

Anthropic - Modely vyvinuté spoločnosťou Anthropic sa zameriavajú na bezpečnosť umelej inteligencie. Na to využívajú metódu „constitutional Al" (dodržujú konkrétny zoznam ústavných princípov a pravidiel). Sú navrhnuté tak, aby zvládli spracovať rozsiahle množstvo informácií. Aktuálne dokážu pracovat's textom až do približne 20 000 slov. Preto sú ideálne na spracovanie rozsiahlych dokumentov, výskumných správ, e-mailov, často kladených otázok, prepisov chatu, záznamov a ďalších. Vlajkovou loďou spoločnosti sú modely Claude 3, ktoré vedia porozumieť prirodzenej konverzácii, zdôvodňovať odpovede a interaktívne sa učiť a viesť inteligentnejšie konverzácie ako iní chatboti. Do tohto modelu investuje aj Amazon.

Gemini - Gemini je rodina veľkých jazykových modelov vyvinutých spoločnosťou Google DeepMind, ktorá slúži ako nástupca modelov LaMDA a PaLM 2. Model Gemini 1.5 uviedol Google v decembri 2023 ako konkurenciu modelu GPT-4 spoločnosti OpenAl s tým, že dokáže v jednom dotaze spracovať oveľa väčšie množstvo informáciínaraz až 1 hodinu videa, 11 hodín zvuku, databáza kódu s viac ako 30 000 riadkov kódu alebo viac ako 700 000 slov.

Všetky generatívne modely AI majú svoje slabiny

Hoci spomínané modely si už našli mnoho fanúšikov, z hľadiska kyberbezpečnosti je pri práci s nimi potrebné uvedomovať si ich potenciálne hrozby. Medzi hlavné riziká generatívnej umelej inteligencie v súvislosti so zadávaním osobných údajov alebo citlivých informácií patria napríklad nasledujúce:

Generatívne modely sa môžu učiť na základe toho, čo do nich používatelia zadávajú. Samozrejme sa to týka aj citlivých informácií. Riziko ich úniku tu je aj napriek tomu, že väčšina modelov určených na platené nasadenie je upravená tak, aby sa z dát klientov neučila.

S rastúcou rýchlosťou generatívnych modelov rastie aj pravdepodobnosť ich zneužitia na útoky na heslá alebo autentizačné mechanizmy spôsobom, kedy s nimi hackeri môžu ľahšie testovať rôzne kombinácie hesiel alebo biometrických dát.

Riziko ich zneužitia za cieľom vytvoriť presvedčivé, ale pritom falošné informácie. To môže viesť k šíreniu dezinformácií a manipuláciám s verejnou mienkou (napríklad v konkurenčnom boji).

Tvorba realistických deepfake obrázkov a videí, ktoré môžu ohroziť dôveryhodnosť médií alebo viesť k identifikácii jednotlivých osôb.

Čo je prompt hacking?

Generatívne jazykové modely sú navrhnuté s dôrazom na etické zásady a bezpečnosť. Hoci sú tieto modely mimoriadne schopné generovať informácie a odpovede na širokú škálu otázok, majú prednastavené obmedzenia, ktoré bránia diskusii alebo šíreniu obsahu týkajúceho sa citlivých tém.

K týmto témam patria návody na výrobu nelegálnych látok, podpora terorizmu, generovanie detskej pornografie a iné nezákonné činnosti. Tieto reštrikcie sú zásadné pre ochranu používateľov a širšej verejnosti pred škodlivým obsahom a zneužitím tejto technológie. V médiách sa ale objavujú správy o tom, ako umelú inteligenciu prinútiť generovať niečo, čo je inak zakázané.

Čo je to prompt?

Prompt je jednoducho to, čo napíšete umelej inteligencii, aby urobila. Tieto inštrukcie riadia, aký druh odpovede alebo výsledku dostanete. Prompt môže byť čokoľvek - veta, otázka alebo dokonca obrázok.

Prompt injection označuje nový spôsob, ako veľké jazykové modely, ako je ChatGPT, zneužiť. Hacker pri ňom vytvorí manipulatívny pokyn, ktorý prinúti jazykový model k odhaleniu citlivých informácií, alebo vygenerovaniu niečoho, pre čo nebol navrhnutý – napríklad písanie malwaru alebo návodu na výrobu bomby.

Predstaviť si to môžete ako preformulovanie požiadavky, kvôli ktorej jazykový model nespozná, že sa hacker pýta na citlivé informácie – napríklad tým, že otázku položí v rámci fiktívneho scenára. Alebo predstiera, že svoju otázku pokladá z určitej úlohy, či ako novinár, alebo spisovateľ, vďaka čomu sa mu môže podariť informáciu z programu vylákať. Tiež sa môže pokúsiť ChatGPT donútiť, aby prezradil interné dáta spoločnosti v rámci žiadosti o pomoc s konkrétnou správou, alebo typom dokumentu.

Viete že...

je možné v platenej verzii ChatGPT vypnúť možnosť, že sa bude Al učiť z vami zadaných dát? Aj to prispieva k väčšiemu súkromiu vašich firemných dát.

A práve preto je nutné, aby zamestnanci boli pri práci s AI chatbotmi vo vzťahu k informáciám veľmi opatrní. Nepoučeným zamestnancom môžu chýbať relevantné informácie alebo správne perspektívy v oblasti bezpečnosti, ochrany súkromia a dodržiavania predpisov. To môže podniky vystaviť veľkému riziku. Zamestnanec by napríklad mohol nevedomky vložiť obchodné tajomstvo do verejne prístupného modelu umelej inteligencie, ktorý sa neustále trénuje na základe užívateľských vstupov, alebo použiť materiál chránený autorskými právami na trénovanie vlastného firemného modelu na generovanie obsahu a vystaviť svoju spoločnosť právnemu postihu.

Ide o širší problém, ktorý nesúvisí len s pokročilými konverzačnými modelmi umelej inteligencie, ako je spomínaný ChatGPT, ale môže sa týkať aj rôznych aplikácií, napríklad jazykových prekladačov založených na umelej inteligencii.

5 typov dát, ktoré by ste nikdy nemali zdieľať s Al chatbotmi

1. Citlivé firemné informácie: Akékoľvek informácie týkajúce sa vašej spoločnosti môžu byť zneužité. Hrozí aj únik informácií, ktorý môže mať vážne následky.

2. Tvorivé diela a duševné vlastníctvo: Pôvodný obsah, vrátane textov, by nemal byť zdieľaný s chatbotmi, aby nedošlo k nežiaducemu využitiu alebo porušeniu autorských práv.

3. Finančné informácie: Citlivé finančné údaje, ako sú bankové účty či čísla kreditných kariet, by nemali byť zdieľané s Al chatbotmi kvôli riziku zneužitia.

4. Osobné údaje: Vaše osobné informácie, ako meno, adresa a telefónne číslo, by mali zostať súkromné, aby nedošlo k zneužitiu identity alebo podvodom.

5. Užívateľské mená a heslá: Heslá a prihlasovacie údaje by nemali byť zdieľané s chatbotmi, aby nedošlo k ohrozeniu vašej online bezpečnosti.

Ako správne nastaviť využívanie AI vo firme?

Okrem ostražitosti pri zdieľaní dát, je kľúčové vytvoriť jasné pravidlá a smernice pre prácu s AI nástrojmi v organizácii a dodržiavanie týchto interných pravidiel vyžadovať.

Tiež je dôležité overiť, ako s dátami pracuje poskytovateľ nástroja. Zistiť, či a ako poskytovateľ ukladá a využíva vaše vstupné dáta. Ak to nástroje umožňujú, zakážte učenie na vašich dátach alebo využívajte izolované inštancie, ktoré nikam neposielajú vaše dáta. Zďaleka najbezpečnejšou metódou na použitie generatívnej umelej inteligencie je prevádzkovať súkromné modely vo vlastnej infraštruktúre.

A v neposlednom rade je nevyhnutnou súčasťou internej stratégie aj vzdelávanie a školenie zamestnancov. Zaistite pravidelné školenia týkajúce sa digitálnej gramotnosti, potenciálnych rizík a etiky pri používaní AI.

Čo si z článku odniesť?

Modely generatívnej umelej inteligencie trpia množstvom zraniteľností, ktoré je možné zneužiť prostredníctvom tzv. prompt hackingu.

Prompt hacking tieto medzery využíva najmä pri jazykových modeloch, kedy sa snaží prostredníctvom klamlivých vstupných požiadaviek (promptov) z modelu získať citlivé informácie, ktoré do neho niekto neprezieravo zadal.

Únik citlivých dát prostredníctvom chatbotov nie je len teoretický, v praxi zasiahol napríklad spoločnosť Samsung Electronics, ktorá kvôli nemu zakázala zamestnancom ChatGPT používať.

Zamestnanci by preto mali byť v rámci kyberbezpečnostných školení poučení o tom, ktoré informácie by nemali zdieľať s nástrojmi ako ChatGPT a ďalšími podobnými platformami.